存算一體

重塑 AI 運算未來

深入探索 CIM 技術如何突破馮紐曼架構的記憶體牆,

以及它在未來 AI 晶片市場中的關鍵角色

突破馮紐曼架構的 記憶體牆

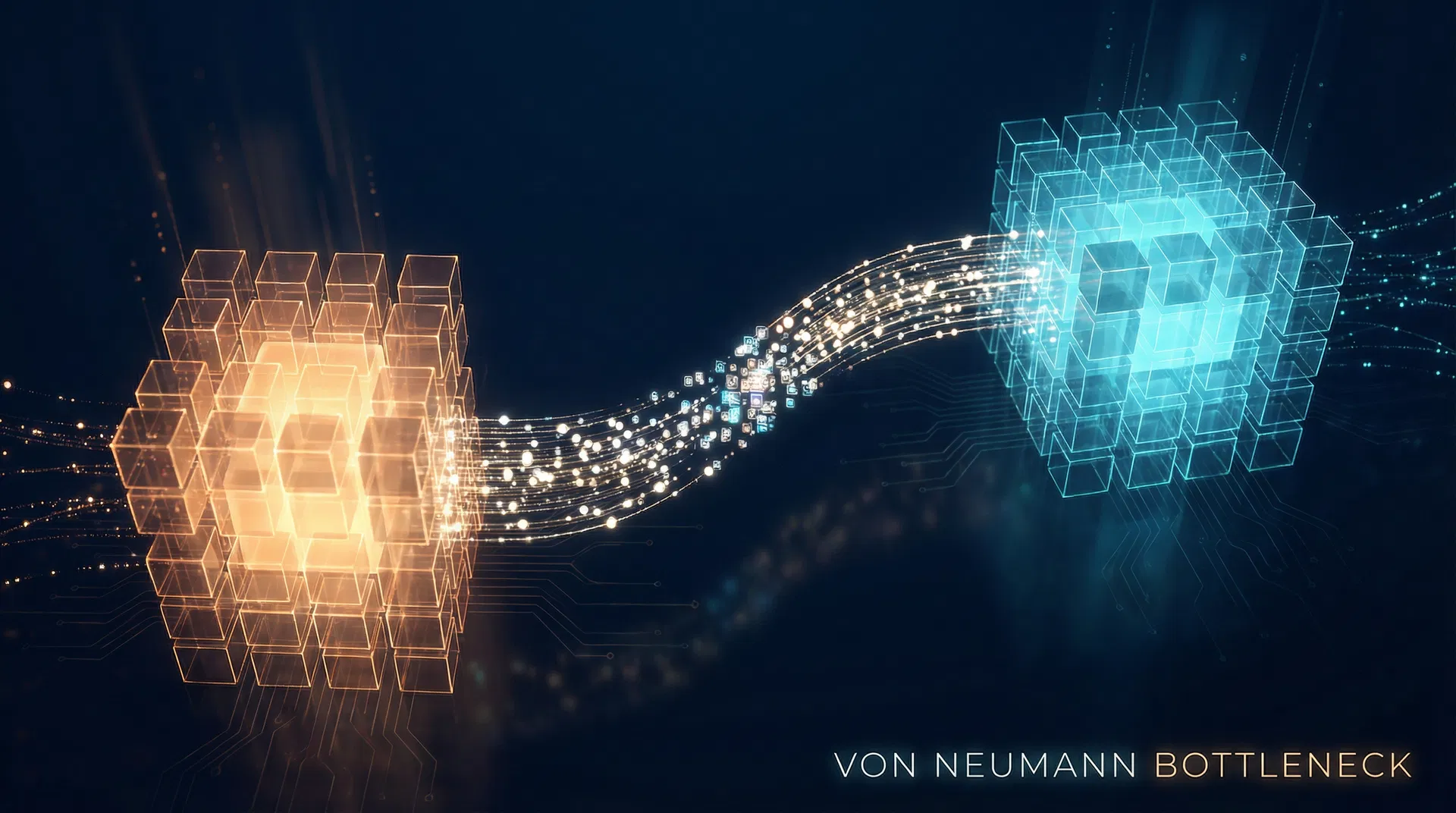

傳統的馮紐曼(von Neumann)運算架構將處理器與記憶體分離,數據需在兩者間頻繁傳輸,形成了所謂的「記憶體牆」瓶頸。隨著 AI 模型規模爆炸性增長,數據搬運的延遲與功耗已成為限制 AI 算力提升的關鍵枷鎖。

為此,「存算一體」(Computing In Memory, CIM)技術應運而生。其核心理念是在記憶體單元內直接執行計算,將數據儲存與邏輯運算在物理層面高度整合,從根本上消除了數據來回搬運的開銷。

核心概念:讓計算在數據駐留之處即時發生,而非將數據搬運至處理器——這是對「計算本質」的重新定義。

馮紐曼瓶頸示意:處理器(暖色)與記憶體(冷色)間的數據通道成為效能瓶頸

馮紐曼架構 vs CIM 架構

點擊切換,比較兩種架構的數據處理流程差異

數據需在處理器與記憶體之間反覆搬運,造成延遲與功耗瓶頸

CIM 技術發展歷程

馮紐曼架構誕生

處理器與記憶體分離的經典運算範式確立,奠定現代電腦基礎。

記憶體牆問題浮現

AI 模型規模急速膨脹,數據搬運的延遲與功耗成為算力提升的關鍵瓶頸。

CIM 技術興起

存算一體概念從學術走向產業,多家廠商開始投入 SRAM/ReRAM-based CIM 晶片研發。

產業化落地加速

聯發科天璣 9500 導入 CIM 架構,NVIDIA 斥資 200 億美元取得 Groq LPU 技術授權。

多架構並行時代

CIM 量產滲透率預計突破 35%,AI 晶片正式進入 LPU、GPU、TPU 多架構並行的新世代。

AI 邊緣運算的 賦能者

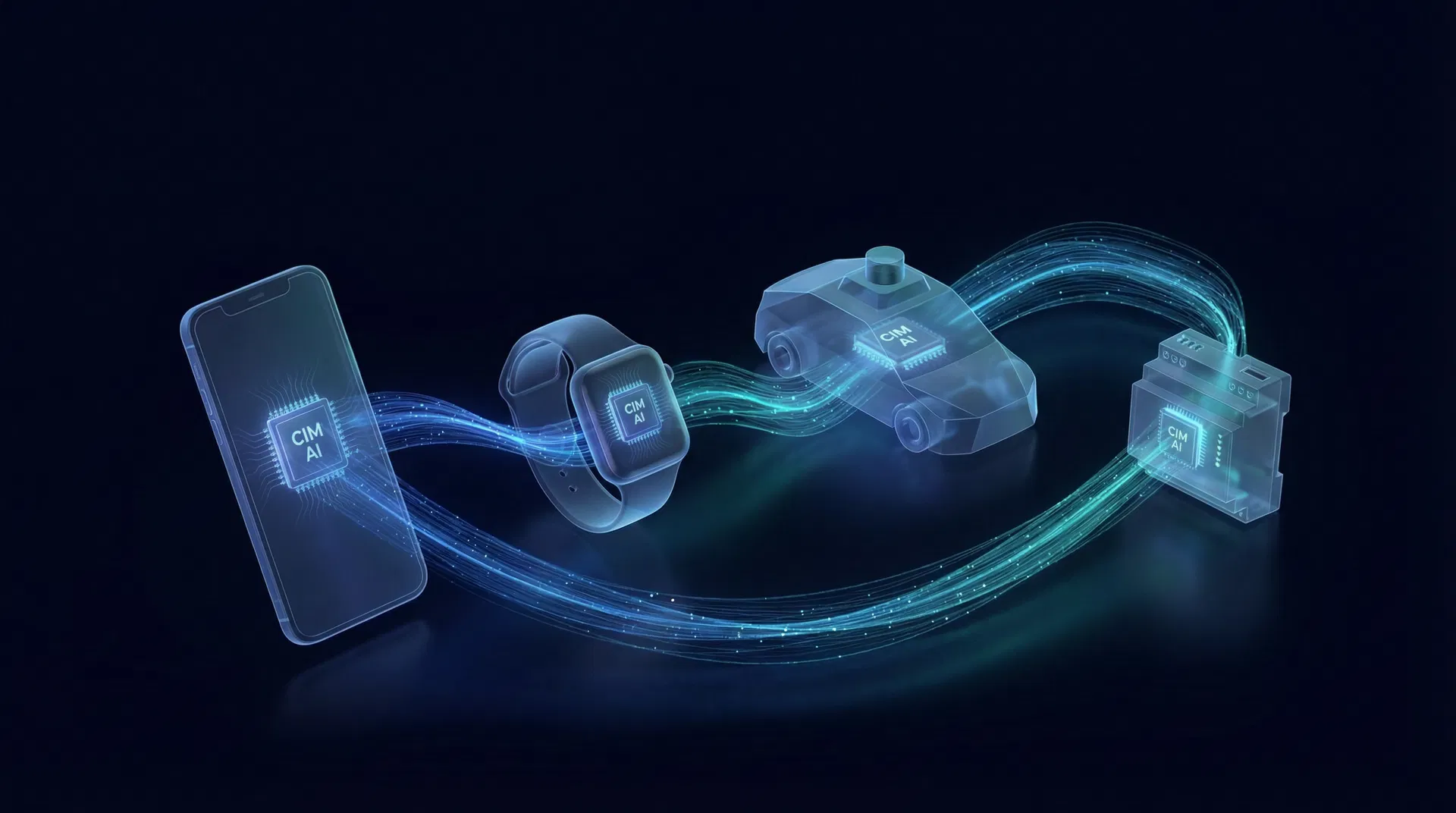

在當前的 AI 晶片市場,CIM 技術主要扮演著「邊緣運算賦能者」與「特定領域加速器」的角色,其最大優勢在於極高的能源效率和低延遲特性。

CIM 技術賦能各類邊緣 AI 裝置:手機、穿戴裝置、自駕感測器、工業 IoT

聯發科天璣 9500

首款導入存算一體架構的旗艦 NPU

Groq LPU

SRAM CIM 架構語言處理器

AI 晶片市場趨勢與預測

2020–2030 年全球 AI 晶片市場規模與 CIM 滲透率預估

- 市場規模(十億美元)

- CIM 滲透率(%)

資料來源:綜合 Gartner、IDC、TrendForce 等研調機構預估

成本與生態系的 雙重考驗

儘管前景看好,CIM 技術的發展仍面臨挑戰。基於 SRAM 或新型記憶體(如 ReRAM、MRAM)的 CIM 晶片,其製造成本與晶片面積相較於傳統 DRAM 仍有劣勢。許多 CIM 架構採用模擬運算,雖然能效極高,但運算精度不如數位電路。

製造成本

SRAM 集成度較低、需占用較大晶片面積,成本相對偏高

運算精度

模擬域計算的非理想性(相位噪聲、耦合串擾)限制高精度應用

生態系統

需要全新的軟體堆疊、編譯器與演算法,開發者生態尚未成熟

CIM 架構:數據在記憶體陣列中流動,無需外部搬運

未來發展方向

從單點突破到 異構融合

與其說存在單一技術能「取代」CIM,不如說更高層次的「異構融合」系統設計,正成為包容並超越 CIM 單點優勢的未來趨勢。

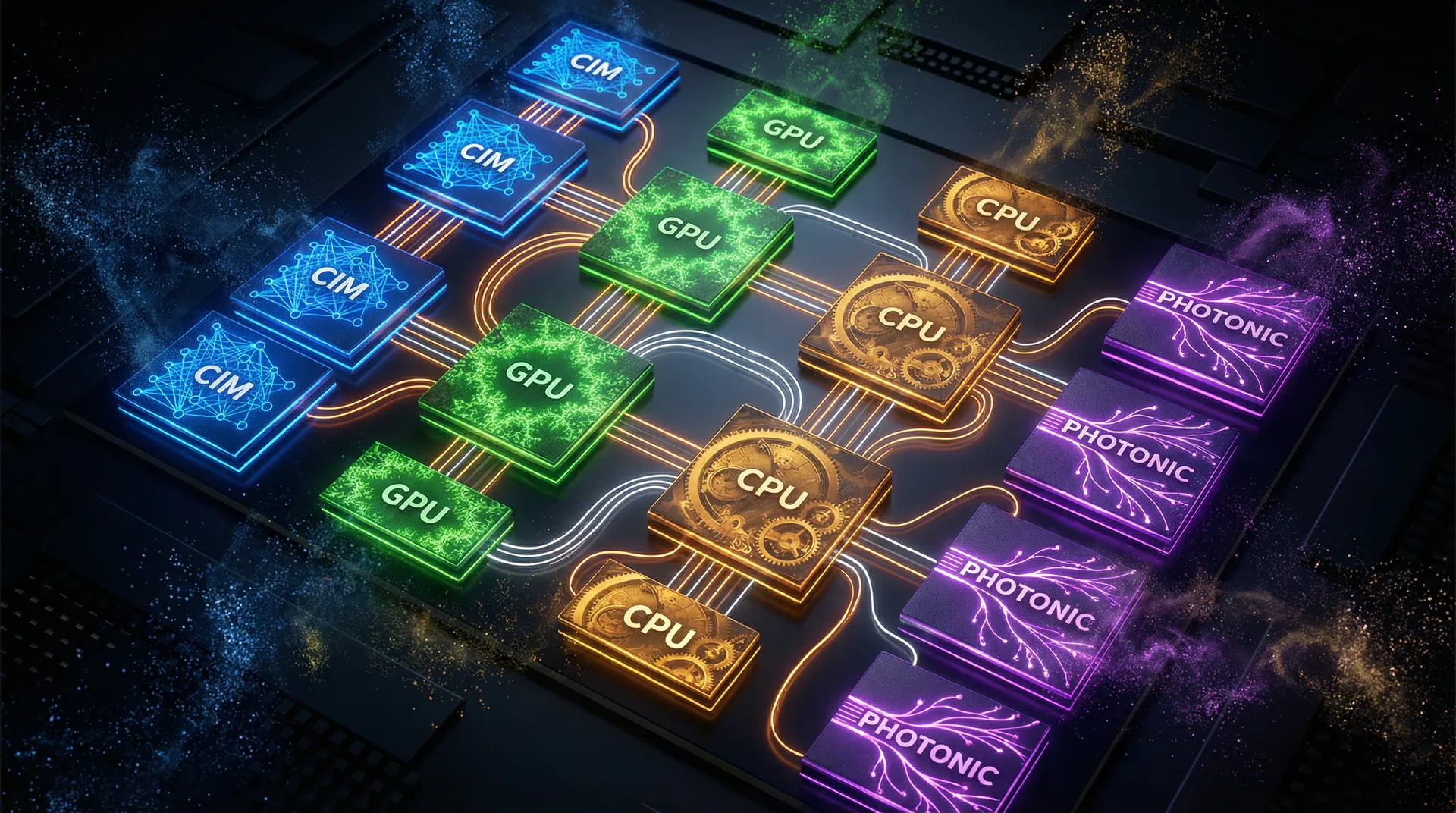

異構融合系統:CIM(藍)、GPU(綠)、CPU(金)、光計算(紫)各司其職,透過先進封裝技術整合

Chiplet 小晶片

先進封裝技術整合多種運算單元

光計算

以光子取代電子進行運算

量子-經典混合

量子協處理器處理特定子任務

關鍵洞察:這些技術與 CIM 並非絕對的競爭關係。在異構融合框架下,CIM 負責處理最鄰近數據的高密度矩陣運算,光計算模組承擔高維特徵的預編碼,量子協處理器則在權重空間中快速採樣最優路徑。未來它們更可能被整合於同一個異構系統中,共同構建一個更多元、更高效的 AI 運算體系。

結論

Computing In Memory(CIM)技術在未來 AI 晶片市場中,將扮演一個不可或缺的關鍵角色,尤其是在對能效與延遲有嚴苛要求的邊緣 AI 領域。

它並非萬靈丹,但其突破馮紐曼瓶頸的核心價值,使其成為 AI 硬體軍備競賽中的重要棋子。然而,單靠 CIM 本身難以建立一個壟斷性的產業生態鏈。更高層次的系統設計趨勢,正朝向「異構融合」發展,也就是將 CIM、Chiplet、光計算等多種架構整合,形成一個協同工作的複雜系統。

CIM 未來不會被單一技術輕易取代,而是會作為一個核心 IP,被整合進更宏大的系統級架構中,成為推動整個 AI 產業持續演進的堅實支點之一。

| 技術路線 | 核心優勢 | 主要挑戰 | 與 CIM 關係 |

|---|---|---|---|

| CIM 存算一體 | 消除記憶體牆、極低功耗 | 成本、精度、生態系 | 核心技術 |

| Chiplet 異構整合 | 模組化、靈活擴展 | 互連標準、良率 | 整合平台 |

| 光計算 | 8 倍能效比、低延遲 | 工藝成熟度 | 協同互補 |

| 量子混合架構 | 超算力、組合優化 | 工程驗證階段 | 長期互補 |